KI in der Videoproduktion: passende Tools und wichtige Tipps

Bilder, Animationen bis hin zu Script und Musik – all diese Inhalte können KI-Generatoren bereits erstellen. Aber all diese Möglichkeiten kombinieren und damit komplette Videos erstellen? Genau das hat Michael Schmidt gemacht und gibt euch hier einen Ein- und Ausblick in die Videoproduktion mit KI.

LESERTEST:Videoproduktion mit Künstlicher Intelligenz - ein Gastbeitrag von Michael Schmidt

LESERTEST:Videoproduktion mit Künstlicher Intelligenz - ein Gastbeitrag von Michael Schmidt

In der Videoproduktion ermöglichen künstliche Intelligenzen neue Wege der Kreativität und Effizienz. Dieser Artikel beleuchtet die revolutionäre Integration von KI in den Prozess der Erstellung von Videos, illustriert am Beispiel von Projekten wie „Daniel Ahrens sein Bein“ und „Hille Feiken“, zwei Videos über historische Personen der Lokalgeschichte. Michael Schmidt erklärt wie er anhand von KI-Tools die Strukturierung von Inhalten erledigen lässt, unterschiedliche Perspektiven ermöglicht und historische Visualisierungen neu interpretieren lässt. Dabei wird deutlich, wie KI die visuelle und narrative Gestaltung transformiert und den Produktionsprozess selbst revolutioniert: von der Auswahl der Sprechstimmen über die Generierung von Bildern und Bewegtbildern bis hin zur musikalischen Untermalung. Der Artikel wirft zudem einen Blick auf die ethischen Überlegungen und Herausforderungen, die mit dem Einsatz von KI in der kreativen Produktion einhergehen, und reflektiert über die Zukunft von Videoproduktionen im Zeitalter der Künstlichen Intelligenz.

Michael Schmidt setzt auf seinem YouTube-Kanal unter anderem Projekte mittels KI um, darunter eine dreiteilige Serie um die historische Figur der Hille Feiken.

VON DER IDEE ZUM SCRIPTFür die Kondensation und Strukturierung der Inhalte setze ich auf ChatGPT. Ein gutes Beispiel hierfür ist das Video über „Daniel Ahrens sein Bein“, einer lokalen Überlieferung aus dem 19. Jahrhundert, dass den Konflikt zwischen Preußen und dem Königreich Hannover in der Gemeinde Wagenfeld im heutigen Landkreis Diepholz aufgreift. Aus einer ursprünglich siebenseitigen Erzählung, die ich vom Stadtarchiv Wagenfeld bekommen hatte, schuf ChatGPT ein prägnantes Skript für ein etwa dreiminütiges Video. Das ermöglicht es mir, mich auf das Wesentliche zu konzentrieren, indem es beispielsweise ausführliche Beschreibungen von Personen oder Umgebungen, die im Video sichtbar sind, weglässt.

Ein weiteres Projekt ist die Vidusalisierung der Überlieferung von Daniel Ahrens. Auch hier wurden Bild und Ton mittels Ki umgesetzt.

Beim Video über Hille Feiken, einer Wiedertäuferin aus dem 16. Jahrhundert, war zur Erforschung der historischen Person umfangreiche Recherche nötig. So griff ich sowohl auf Online-Quellen als auch auf spezifische Informationen vom Stadtarchiv Münster und dem Landesverband Westfalen-Lippe (LWL) zurück. Mit diesen zusätzlichen Daten konnte ChatGPT ein facettenreiches Video-Skript mitsamt Dialogen erstellen, was mich durch die Perspektivenvielfalt dazu inspirierte, gleich drei Videos zu produzieren: Eines aus der Sicht der Wiedertäufer, eines aus der Perspektive der katholischen Kirche von vor 500 Jahren und eines, das Hille Feiken aus heutiger Sicht betrachtet. War sie eine Heldin, eine Märtyrerin ihres Glaubens, oder das Produkt einer extremen Ideologie? Dabei bleiben in allen drei Videos die Bilder gleich, nur der Text ändert sich in den entsprechenden Sichtweisen. Auch das kann ChatGPT sehr gut. Dazu gibt man gibt der KI das Skript aus der Sicht der Wiedertäufer und sagt der KI, es soll den Text aus der Sicht der katholischen Kirche vor 500 Jahren, mit gleichen Textbausteinen und gleicher Skriptlänge machen. Nach ein paar Änderungen an der einen oder anderen Stelle, passt dass dann schon gut. Die Arbeitserleichterung ist auf jeden Fall enorm.

ChatGPT: Das KI-Modell von OpenAI hat den Hype um KI ausgelöst und ist in erster Linie für Texterstellung gedacht. Dabei kann es die Kondensation und Strukturierung von Inhalten übernehmen und ausführliche Skripte aus bestehenden Geschichten oder Daten generieren. In der Version 4 kann das Tool auch Bilder generieren, wofür man allerdings die kostenpflichtige Plus-Version benötigt.

VOM SCRIPT ZUM BILDIn der digitalen Ära, wo der Inhalt König ist und das Format seine Burg, steht jeder Schöpfer irgendwann vor der Entscheidung, entweder den Konventionen zu folgen oder einen eigenen Weg zu gehen. Beim Start meines neuesten Projekts im Videoschnittprogramm stand ich genau vor dieser Wahl. Das erste Bild, das ich importierte, war eine historische Zeichnung von Hille Feiken, deren Format weit entfernt von modernen Standards lag. Mit einem Seitenverhältnis von etwa 0,71:1 näherte es sich einem 5:7 Format an – ein ungewöhnliches Maß in einer Zeit, in der vertikale Formate wie 9:16 oder 4:5 auf Plattformen wie Instagram, TikTok und sogar YouTube mit seinen Shorts dominieren. Ich entschied mich aber, das Bildformat auch in das Video zu übernehmen und nicht zu klassischen Hoch- oder Querformaten zu wechseln. Das war tief mit meinem kreativen Vorhaben verwoben: eine Überblendung von der historischen Zeichnung zu einem von Künstlicher Intelligenz generierten Bild. Obwohl die historische Originalzeichnung erst 100 Jahre nach Hilles Tod angefertigt wurde, war es mein Ziel, dieser treu zu bleiben. Das Ergebnis ist ein Video mit einem unverwechselbaren Seitenverhältnis, das sich von der Masse abhebt und die Einzigartigkeit des Werks betont. Dieses Vorgehen verleiht dem Endprodukt mehr Charakter und visuelle Identität, in der Hoffnung, dass diese in der flüchtigen Social-Media-Welt einen bleibenden Eindruck hinterlässt

Von Hille Feiken existiert eine historisches Zeichnung, hier mit KI in ein modernes Bild umgesetzt. Als Brücke zur historischen Zeichnung bleiben sowohl modernes Bild als auf Video im historischen Format.

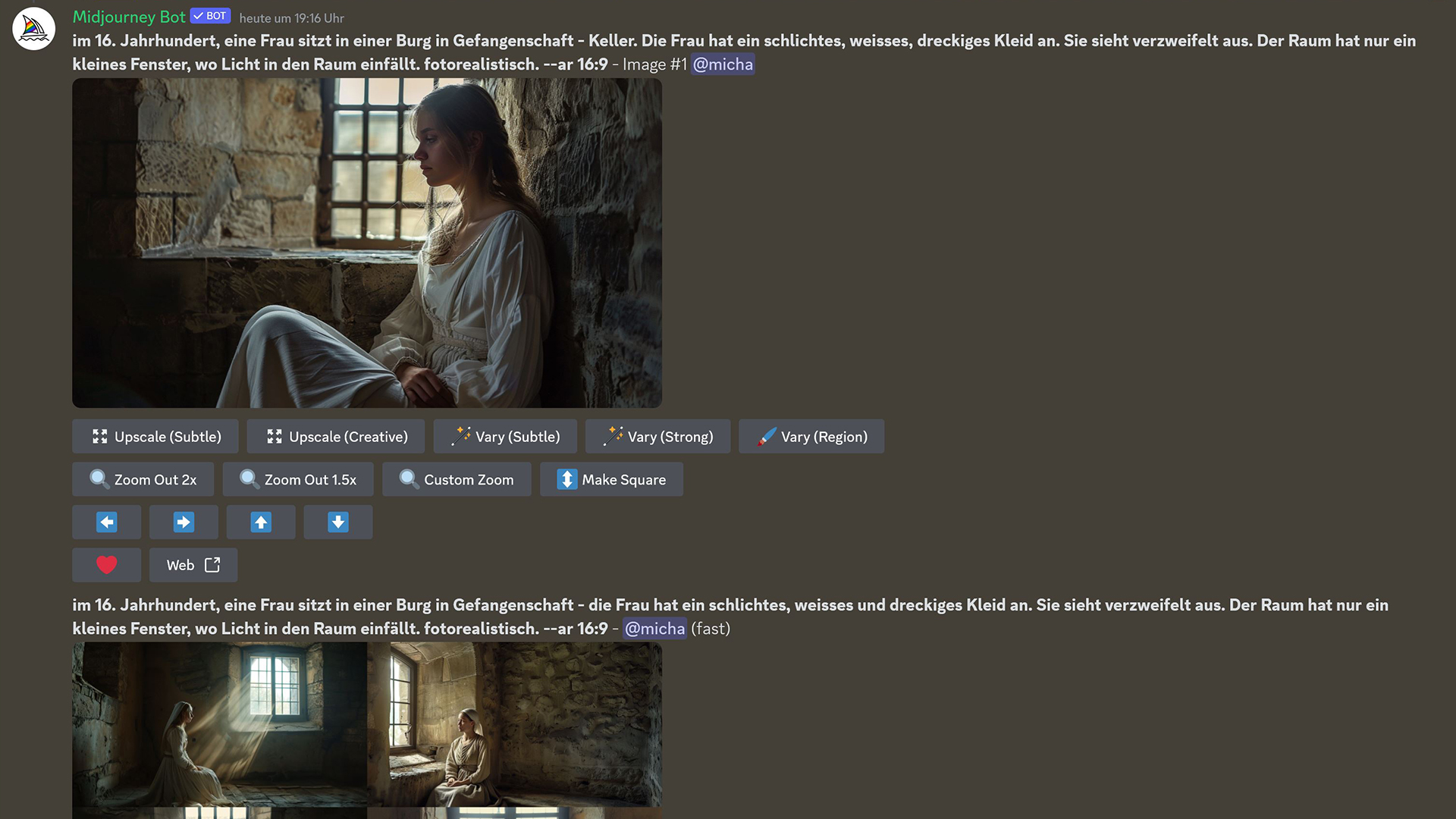

Für die Generierung der Bilder verwende ich ebenfalls ChatGPT, für desen Bilderstellung man jedoch die kostenpflichtige Plus-Version benötigt. Qualitativ bessere Ergebnisse erzielt man mit Midjourney. Dabei stoße ich allerdings gelegentlich an ethische Grenzen, wie zum Beispiel bei der Darstellung von Blut. Um diese Hürden zu umgehen, verwende ich kreative Umschreibungen – wie „Stein mit dunkelroten Farbklecksen“ für das angedeutete Blut in einer Szene aus dem Video über Hille Feiken. Es ist nicht unüblich, dass ich für eine einzige Szene fünf bis zehn Bilder erzeuge und dennoch manchmal mit Photoshop nachbessern muss. Mit der KI Promeai.com kann man zum Beispiel aus Skizzen oder alten Zeichnungen, recht realistische Bilder generieren. So erstellt man schöne Überblendungen von einer historischen Zeichnung in ein realistisches Bild. Verwendet habe ich das für die Burg meines Heimatorts Bevergern, die es bis ins Jahr 1681 gab. Wie sie mal ausgesehen hat überliefert nur eine Zeichnung und aus dieser Zeichnung habe ich dann mit Hilfe von KI ein Farbfoto erzeugt.

Von der heute nicht mehr erhaltenen Burg Bevergern ist nur eine Zeichnung überliefert (roter Rahmen) die zuerst in Photoshop mittels dessen generativer KI auf das Videoformat erweitert und anschließend in Promeai in ein realistisches Bild gewandelt wurde.

CONTINUITY IM BILDBei der Generierung von Bildern mit ChatGPT stelle ich oft fest, dass es eine Herausforderung sein kann, in verschiedenen Fotos dieselbe Person konsistent darzustellen. Die Kontinuität der Charakterdarstellung ist entscheidend, besonders wenn es um die Erzählung einer Geschichte geht, in der die Person über verschiedene Zeitpunkte hinweg zu sehen ist. Es gelingt mal mehr, mal weniger gut, diese Kontinuität zu gewährleisten. Ein Trick ist es ein Referenzbild, zum Beispiel der Person aus früheren Generierungen, wieder hochladen und dieses als Vorlage zu verwenden. Diese Vorgehensweise hilft, die Konsistenz der Charaktere über mehrere Szenen hinweg zu verbessern, obwohl es manchmal immer noch schwierig sein kann, eine vollständige Übereinstimmung zu erzielen. Midjourney hat darauf reagiert und vor kurzem den Character Reference-Parameter eingeführt. Damit funktioniert das „Mitnehmen“ von Aussehen einer Person zum nächsten generierten Bild sehr gut.

Midijourney: Eine KI für die Generierung von Bildern, die qualitativ hochwertige Ergebnisse liefert, oft für die Erstellung von Szenenbildern in Videos verwendet wird, da es eine hohe Anpassungsfähigkeit ermöglicht. Hier im Bild ist Midijorney als Anwendungs-Bot auf einem Server des Anbieters Discord integriert.

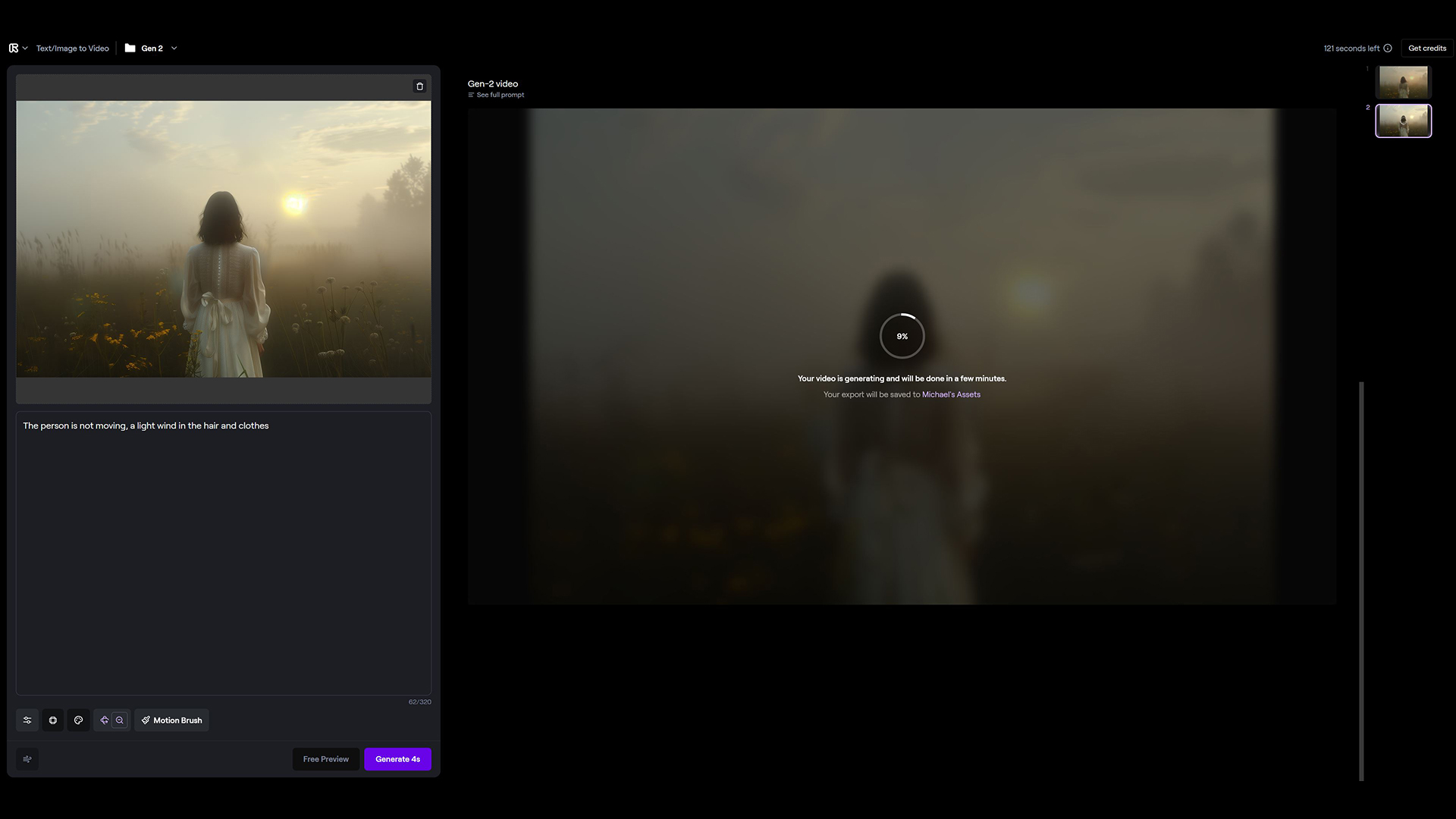

VOM BILD ZUM VIDEOFür die Bewegtbildgenerierung wende ich mich an Runway, die derzeit führende KI auf diesem Gebiet. Dort lade ich die zuvor erstellten Bilder hoch und lasse die KI kurze Videosequenzen von bis zu vier Sekunden Länge generieren. Die Möglichkeiten zur Anpassung, wie Kamerafahrten oder das Maskieren bestimmter Bildbereiche, eröffnen kreative Freiheiten, auch wenn die KI bei der Bewegung von Menschen und Tieren manchmal noch zu unerwarteten Ergebnissen führt. Wer schonmal mit KI-Werkzeugen versuche gemacht hat weiß, dass die Video-KI Personen oder Tiere in der Bewegung oft nicht richtig darstellen kann. Deshalb lässt man Personen sich nur ganz wenig oder gar nicht bewegen. Beispielsweise gibt man die Anweisung: „Person soll sich nicht bewegen, leichter Wind, sichtbar an den Haaren der Person oder an der Kleidung.“ So hat man ein wenig Dynamik im Bild, ohne dass die Person sich unnatürlich verändert, ein drittes Bein bekommt oder rückwärtsläuft.

Runway: Die führende KI für die Erzeugung von Bewegtbildern erzeugt aus statischen Bildern kurze Videosequenzen. Sie bietet verschiedene Anpassungsmöglichkeiten für die Bewegung und kann dynamischer Szenen durch Kamerabewegungen erstellen.

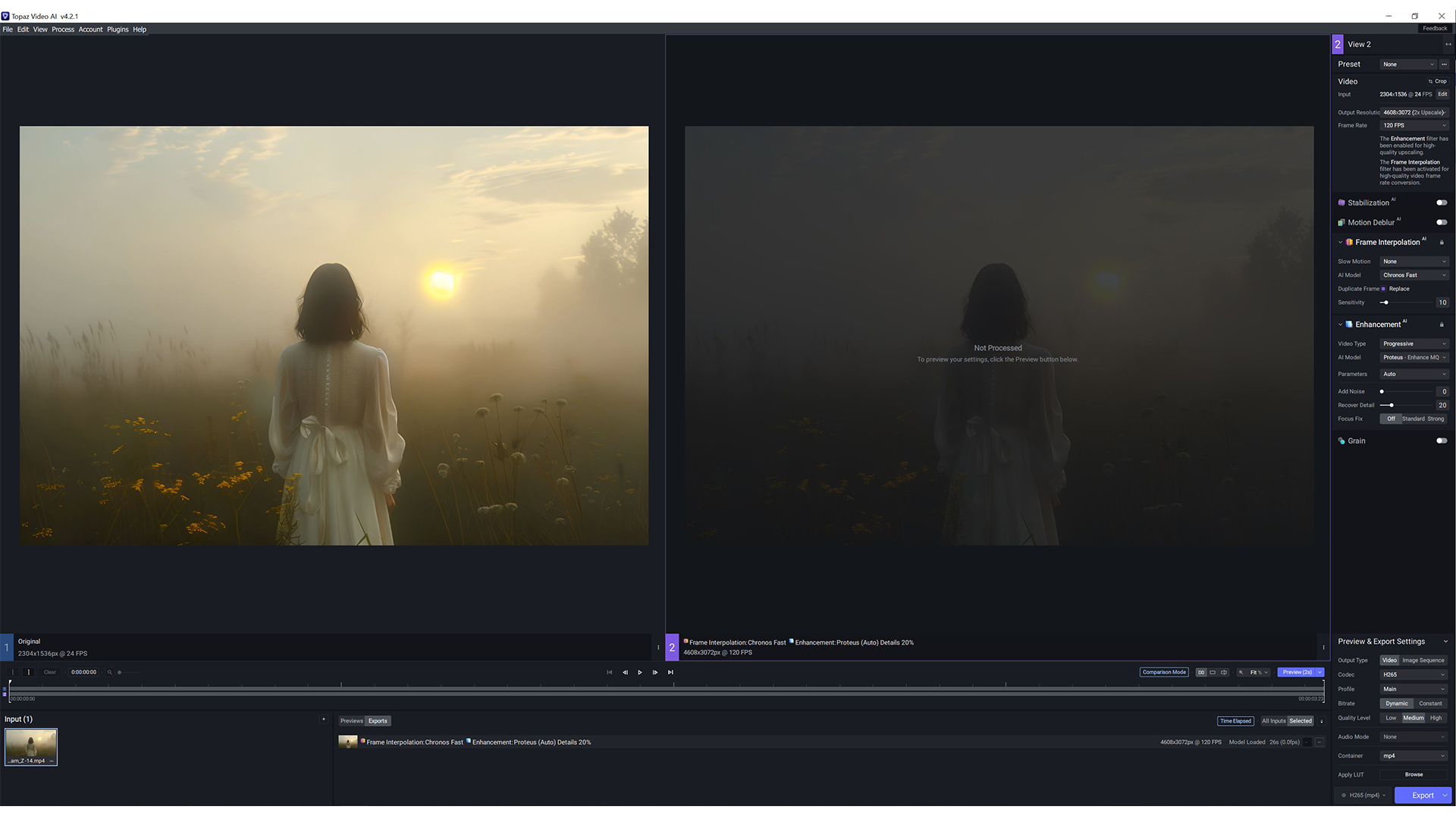

Nach der Erstellung der Bewegtbilder mit Runway gehe ich einen Schritt weiter, um die Qualität und Flexibilität des finalen Videos zu erhöhen. Ich verwende Topaz Video AI, um das Material auf 4K aufzupumpen und die Bildrate von 24 Bildern pro Sekunde auf 60 oder sogar 120 Bilder pro Sekunde zu erhöhen. Dies gibt uns die Möglichkeit, die Szenen im Nachhinein durch Zeitlupen zu verlängern, was eine größere kreative Flexibilität in der Postproduktion ermöglicht. Abschließend füge ich die einzelnen Szenen mit meinem Videoschnittprogramm zusammen, um das finale Produkt zu erstellen.

Topaz Video AI: Eine KI, die verwendet wird, um Videoqualität zu verbessern, indem die Auflösung erhöht und die Bildrate angepasst wird. Dieses Tool ermöglicht so eine größere Flexibilität in der Postproduktion.

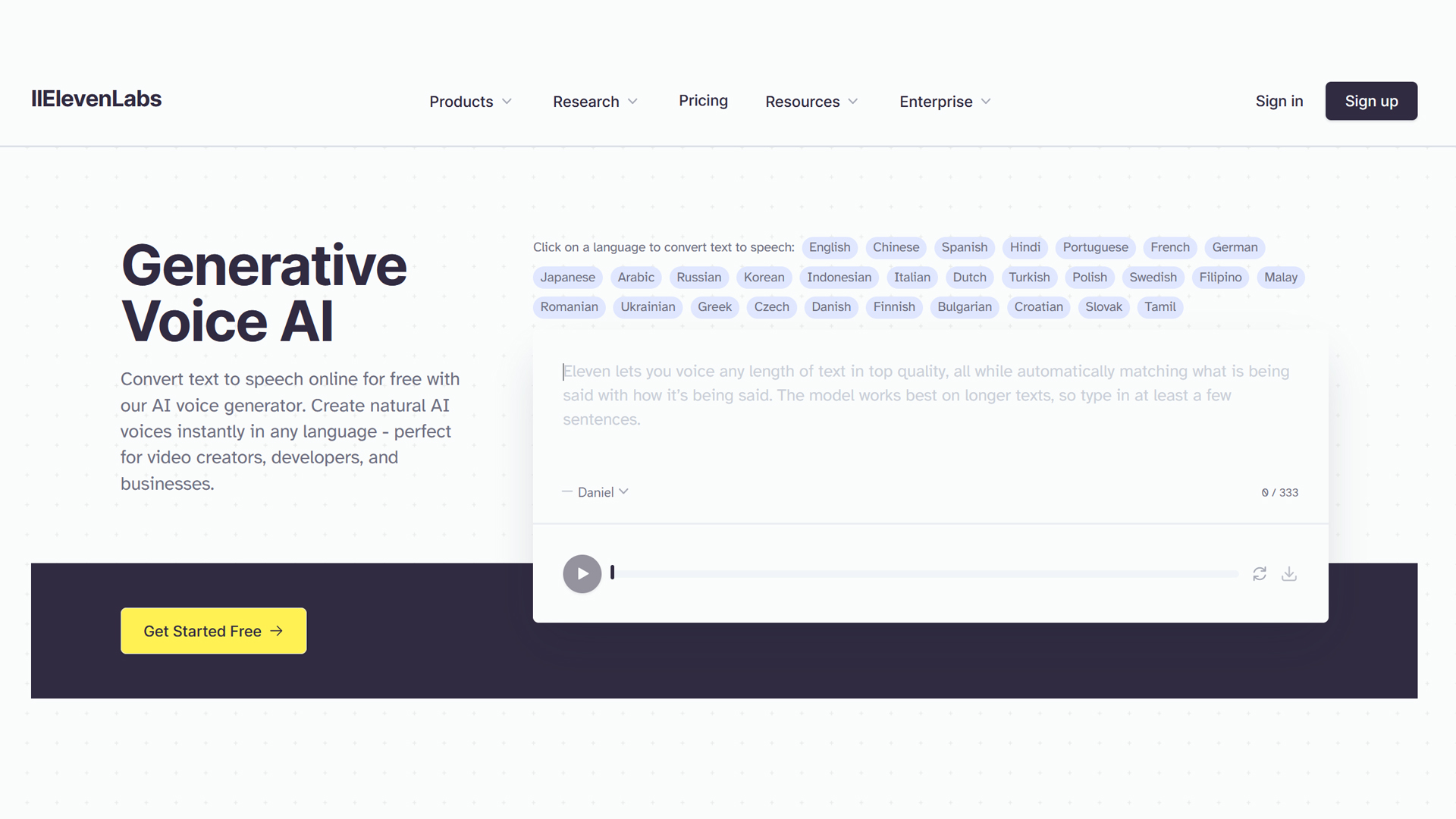

KI FÜR DEN TONSowohl in „Daniel Ahrens sein Bein“ als auch in „Hille Feiken“ kommen Sprecherstimmen vor – natürlich KI-generiert. Für die Wahl der Sprechstimme nutze ich ElevenLabs. Die Anwendung erlaubt es mir, aus einer umfangreichen Bibliothek die passende Stimme zu wählen oder bei Bedarf meine eigene zu klonen. Das ist im Besonderen dann interessant, wenn man von Nervosität nicht fehlerfrei lesen kann oder aber eine andere Sprache für den Film haben möchte. Das zuvor erstelle Video Skript oder die Übersetzung wird dort dann einfach einkopiert und die entsprechende Stimme ausgewählt. Das Ergebnis ist eine Stimme, die im Vergleich zu „echten“ Sprechern vielleicht nicht die gleiche Emotionen rüberbringt, aber dennoch eine saubere Stimme mit inzwischen korrekter Aussprache und Betonungen bietet.

Elevenlabs: Die KI-Plattform bietet eine Bibliothek an Stimmen und bietet die Möglichkeit die eigene Stimme zu klonen. Damit eignet sie sich, um Skripte zu vertonen und so den Videos eine passende akustische Ebene zu geben.

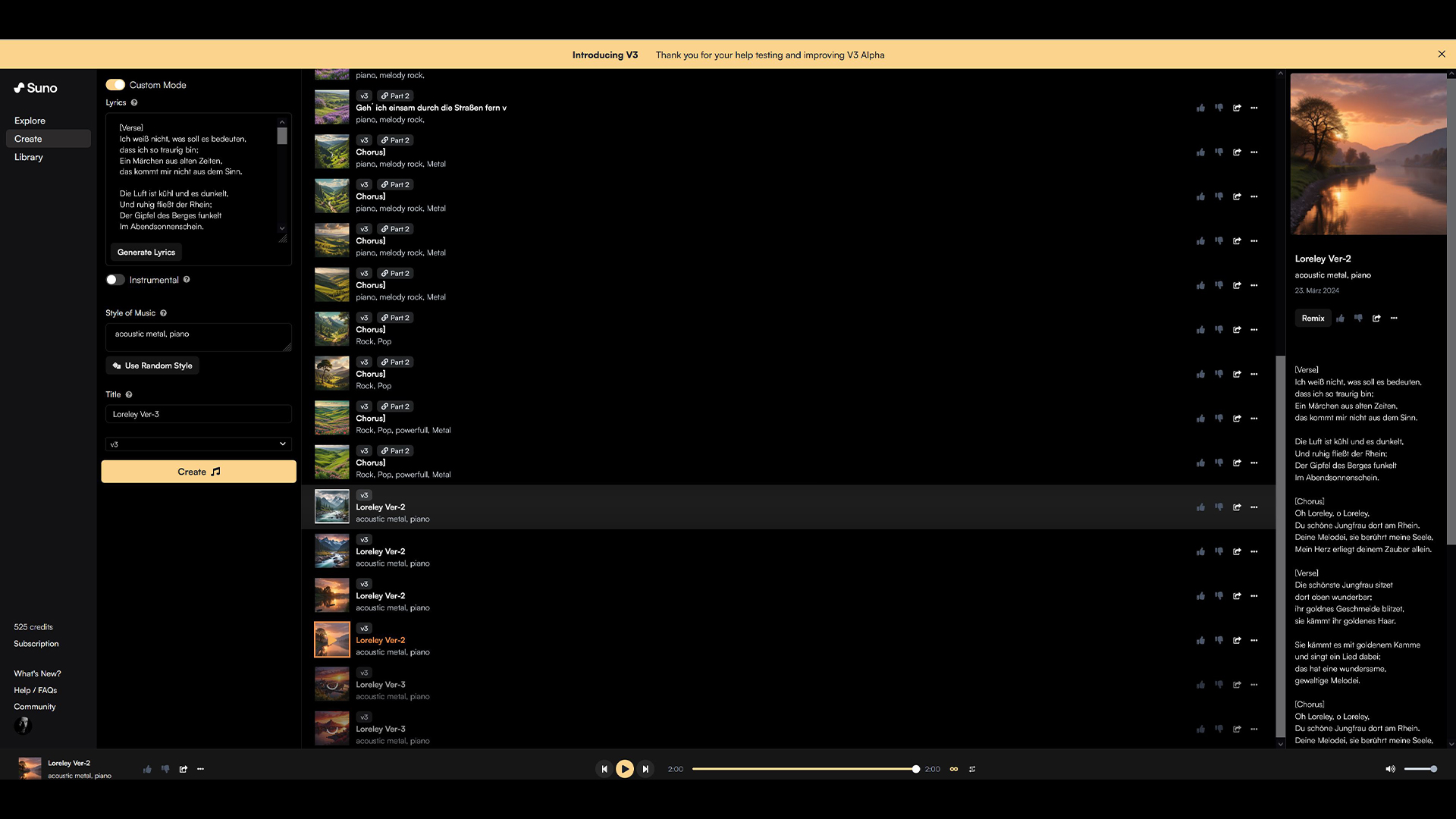

Mittlerweile kann man auch Musik mit Hilfe von KI machen. Mein erstes KI-Video in dieser Art ist „Heilung“, bei dem alles – von den Bildern bis hin zu den Instrumenten und der Gesangsstimme – KI-generiert ist, basierend auf einem Gedicht, das eine Bekannte geschrieben hat. Für die Musik nutze ich suno.ai, eine KI, die es ermöglicht, komplexe Musikstücke und Gesang zu erzeugen. Bei der klassischen Musik der beiden Filme griff ich jedoch auf "menschliche" Werke zurück.

Suno.ai: Die KI ist auf die Erzeugung von Musik und Gesang spezialisiert. Sie ermöglicht es, komplexe Musikstücke basierend auf Vorgaben oder Themen zu komponieren, und kann sogar Gesangsstimmen generieren, die zu den musikalischen Kompositionen passen.

FAZIT UND AUSBLICKNoch vor etwa anderthalb Jahren erzeugten Bildgenerierungs-KIs oft Ergebnisse, die zwar kreativ und unterhaltsam waren, aber in vielen Anwendungsfällen nicht wirklich brauchbar. Die Bilder waren häufig durch offensichtliche Artefakte oder Unstimmigkeiten gekennzeichnet, die sie klar als Produkte einer KI erkennbar machten – man denke nur an Hände mit zu vielen oder zu wenig Fingern. Die Entwicklung ist jedoch so rasant, dass wir heute an einem Punkt stehen, an dem künstlich generierte Bilder oft kaum noch von echten Fotografien zu unterscheiden sind. Diese Verbesserung in der Bildqualität hat die Tür für weitere Anwendungen geöffnet, von der Erstellung realistischer Grafiken für die Unterhaltungsindustrie bis hin zur Generierung von Bildmaterial für Bildungszwecke. Ähnliche Fortschritte zeichnen sich auch im Bereich der Video-KIs ab. Die Entwicklung von KI-generierten Videos hat in den letzten Monaten erhebliche Fortschritte gemacht. Die letzten Entwicklungen zeigen einen weiteren, deutlichen Qualitätssprung im Vergleich zu den früheren Versionen – man denke nur an Sora von OpenAI, eine Video-KI, welche die ganze Videoproduktion nochmal auf ein ganz anders Level heben kann, wenn sie den gezeigten Teasern und Versprechungen gerecht wird.

Trotz der Unterstützung durch KI und jahrzehntelanger Erfahrung im traditionellen Videoschnitt, erfordert die Produktion eines KI-gestützten Videos weiterhin seine Zeit. So beanspruchte das Projekt „Heilung“ beispielsweise 40 Stunden Produktionszeit. Dies lässt sich unter anderem auf die gelegentlichen Unstimmigkeiten in den generierten Fotos und Videos zurückführen, die noch nicht immer den Erwartungen entsprechen. Wie lange KI braucht, um auch diese letzten Fehler zu beheben, ist jedoch wohl nur noch eine Frage der Zeit.

Von Musikvideos bis hin zur kreativen Darstellung historischer Ereignisse und Geschichten – die vielfältigen KI-Technologien eröffnen revolutionäre Wege, Inhalte visuell eindrucksvoll zu gestalten. Doch nicht jedes Element muss zwangsläufig aus dem Bereich der KI stammen. Mein nächstes Vorhaben ist ein Musikvideo, inspiriert von den Werken eines bereits verstorbenen Dichters aus meiner alten Heimat, dem Sauerland. Während Instrumente und Gesang mithilfe künstlicher Intelligenz kreiert werden, setze ich für die visuelle Umsetzung auf die bewährte Qualität meiner Sony A7R V Kamera.

ÜBER DEN AUTOR

Geboren und aufgewachsen im Herzen des Sauerlands, entdeckte Michael Schmidt bereits in jungen Jahren seine Leidenschaft in der Welt der visuellen Künste, angestoßen durch eine geschenkte Agfamatic 4000 Pocketkamera. Michael erlernte zunächst den Beruf des Druckers. Ein Umzug ins Münsterland markierte den Beginn eines neuen Kapitels: eine Weiterbildung zum Webdesigner.Bei NaturaGart, einem Vorreiter in der Konzeption von Garten- und Teichlandschaften, fand Michael nicht nur eine berufliche Heimat, sondern auch eine unerschöpfliche Quelle der Inspiration. Der Park in Ibbenbüren, mit Europa größtem Unterwasserpark, einer Vielfalt an Musterteichen und einem eindrucksvollen Kaltwasseraquarium, wurde zur Bühne für Michaels leidenschaftliche Unterwasseraufnahmen, die er geschickt mit einem modifizierten U-Boot einfängt und auf seinem YouTube-Kanal zusammen mit den KI-Projekten präsentiert. Michael Schmidts Bestreben, die Welt aus neuartigen Blickwinkeln zu erfassen, zeigt sich in seiner fortwährenden Auseinandersetzung mit den neuesten Entwicklungen in der Kameratechnologie und der kreativen Integration von Technologien aus angrenzenden Bereichen, wie beispielsweise dem RC-Modellbau und KI-Technologie.Michael Schmidt auf YouTubeMichael Schmidt auf InstagramMichael Schmidt auf Facebook

Geboren und aufgewachsen im Herzen des Sauerlands, entdeckte Michael Schmidt bereits in jungen Jahren seine Leidenschaft in der Welt der visuellen Künste, angestoßen durch eine geschenkte Agfamatic 4000 Pocketkamera. Michael erlernte zunächst den Beruf des Druckers. Ein Umzug ins Münsterland markierte den Beginn eines neuen Kapitels: eine Weiterbildung zum Webdesigner.Bei NaturaGart, einem Vorreiter in der Konzeption von Garten- und Teichlandschaften, fand Michael nicht nur eine berufliche Heimat, sondern auch eine unerschöpfliche Quelle der Inspiration. Der Park in Ibbenbüren, mit Europa größtem Unterwasserpark, einer Vielfalt an Musterteichen und einem eindrucksvollen Kaltwasseraquarium, wurde zur Bühne für Michaels leidenschaftliche Unterwasseraufnahmen, die er geschickt mit einem modifizierten U-Boot einfängt und auf seinem YouTube-Kanal zusammen mit den KI-Projekten präsentiert. Michael Schmidts Bestreben, die Welt aus neuartigen Blickwinkeln zu erfassen, zeigt sich in seiner fortwährenden Auseinandersetzung mit den neuesten Entwicklungen in der Kameratechnologie und der kreativen Integration von Technologien aus angrenzenden Bereichen, wie beispielsweise dem RC-Modellbau und KI-Technologie.Michael Schmidt auf YouTubeMichael Schmidt auf InstagramMichael Schmidt auf Facebook

Autor: Michael Schmidt / Redaktion: Joachim Sauer, Jonas Schupp / Bilder: Michael Schmidt, Jonas Schupp

Viele weitere spannende Themen, Tests und Ratgeber gibt

Autor: |

Bildquellen: |

Weitere Lesertests

Lesertest: DJI Mic 2 gegen Sennheiser Profile Wireless aus Social Media-Sicht

Profi-Lesertest: Nikon Z50II – mit der kompakten Kamera in Schottland